Veći AI modeli i dalje padaju na testu logike: zašto skaliranje nije rješenje

Najnovija istraživanja pokazuju da problem nije u veličini modela, već u samoj arhitekturi razmišljanja.

Tokom januara 2026. godine, istraživači iz Google DeepMind, Meta, Amazon i Yale University objavili su studiju koja objašnjava zašto i najveći današnji AI modeli i dalje griješe u osnovnoj logici. Iako su modeli sve veći i brži, oni i dalje funkcionišu kao reaktivni sistemi bez sposobnosti stvarnog planiranja, provjere i ispravljanja sopstvenih grešaka.

- Skaliranje modela ne rješava problem logičkog rezonovanja.

- AI sistemi uglavnom reaguju, umjesto da planski razmišljaju.

- Rješenje se vidi u tzv. „logičkoj petlji“.

- Potrebna je jasna podjela između planiranja i izvršenja zadataka.

- Budućnost AI-ja zavisi od agentnih arhitektura, ne od veličine modela.

Analiza: zašto veliki modeli ne razmišljaju

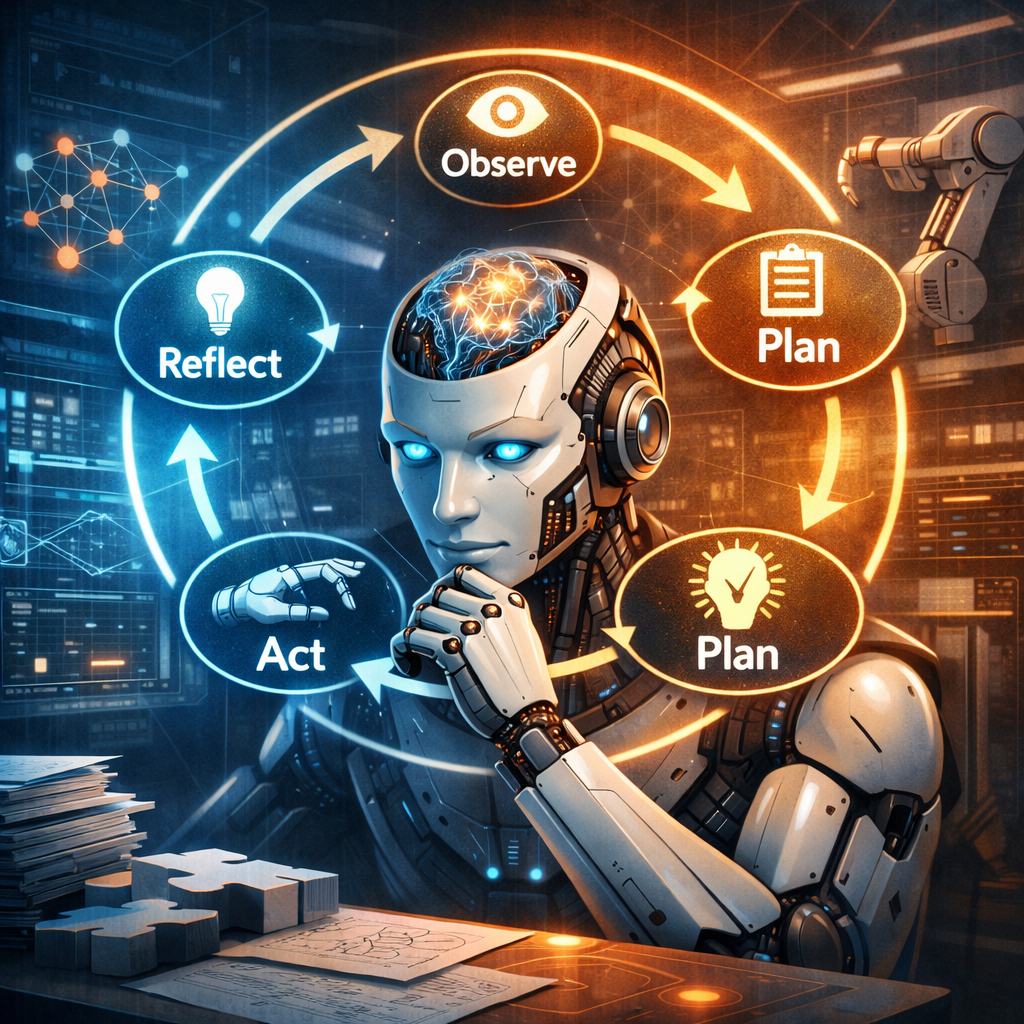

Istraživanje pokazuje da veliki jezički modeli generišu tekst token po token, bez interne strukture koja bi im omogućila da zastanu, procijene rezultat i promijene strategiju. Autori uvode koncept logičke petlje ciklusa posmatranja, planiranja, djelovanja i refleksije. Bez tog ciklusa, modeli ostaju sofisticirani sistemi za automatsko dopunjavanje teksta, a ne pravi agenti.

Ključni nalazi uključuju:

- Razdvajanje uloga: planiranje i izvršenje ne smiju biti u istom koraku.

- Interno stanje zadatka: agent mora znati koji mu je cilj i šta je sljedeći korak.

- Strukturna kontrola: kvalitet dolazi iz arhitekture, ne iz dodatnih podataka.

Tržište i konkurencija: kuda ide industrija

Industrija je godinama fokusirana na skaliranje više parametara, više podataka, veći troškovi. Međutim, ovo istraživanje sugeriše da takav pristup ima ograničenja. Umjesto toga, kompanije počinju da razvijaju „operativne sisteme za AI“, gdje je agentno rezonovanje osnovni sloj.

NVIDIA i Microsoft paralelno rade na specijalizovanim modelima i senzorima, dok Anthropic eksperimentiše sa mapiranjem unutrašnjih stanja modela kako bi ponašanje bilo stabilnije.

Naša perspektiva: šta to znači za region i poslovne korisnike

Za firme u regionu koje koriste AI u poslovanju, ovo znači da sama integracija velikog modela više nije dovoljna. Prednost će imati oni koji:

- Implementiraju agentne tokove rada.

- Dozvoljavaju AI sistemima da provjeravaju sopstvene rezultate.

- Kombinuju modele sa jasnim pravilima i kontrolnim mehanizmima.

AI koji može da zastane i razmisli biće daleko korisniji u analitici, automatizaciji i donošenju odluka nego bilo koji „veći“ model bez logičke strukture.

Zaključak

Skaliranje je dovelo AI do impresivnog nivoa fluentnosti, ali ne i do pouzdanog rezonovanja. Ako industrija ne napravi zaokret ka agentnim arhitekturama i logičkim petljama, budućnost će i dalje zavisiti od brzih, ali ne i promišljenih sistema. Pravi napredak dolazi tek kada AI dobije sposobnost da upravlja sopstvenom logikom.