Kada najveće vojske ne potpisuju Kina i USA ostaju van sporazuma za primjenu AI u vojne svrhe!

Neobavezujući sporazum o vojnoj upotrebi AI-ja potpisale su uglavnom manje države. Kada veliki ostanu po strani, norme postaju test strpljenja, a ne sigurnosti.

U svijetu u kojem se vještačka inteligencija sve brže seli iz laboratorija u infrastrukturu moći, pokušaji da se uvede red često dolaze kasno i sa zadrškom. Nije to zato što niko ne vidi rizike, već zato što ih svi vide i svako se boji da će upravo on ostati korak iza. Vojna upotreba AI-ja je najosjetljivija tačka tog strah tu greška ne znači samo loš proizvod, već političku ili bezbjednosnu krizu.

U tom kontekstu se desio i skup u Španiji, zamišljen kao mjesto gdje će se bar nacrtati zajednička pravila. Nije to bio pokušaj da se ratovi „automatizuju na siguran način“, već skromnija ambicija: dogovor oko osnovnih principa koji bi smanjili rizik od grešaka, nesporazuma i paničnih odluka. Ali već na prvi pogled bilo je jasno da se radi o vježbi dobre volje, ne o obavezujućem sporazumu.

Šta se zapravo desilo

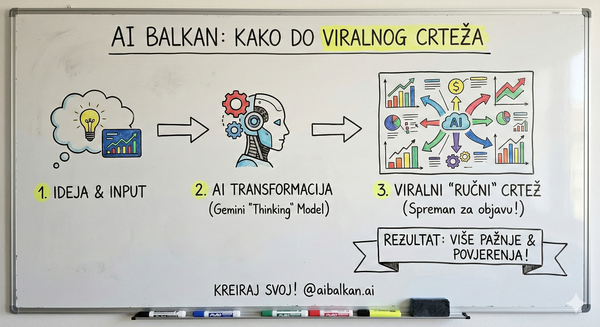

Na REAIM samitu okupilo se 85 država. Njih 35 je potpisalo neobavezujuću deklaraciju sa dvadesetak principa o „odgovornoj vojnoj upotrebi vještačke inteligencije“. Dokument nema mehanizme kontrole, nema inspekcije, nema kazni. Još važnije, dvije zemlje sa najrazvijenijim vojnim AI kapacitetima – SAD i Kina – ostale su po strani.

Drugim riječima, dobili smo tekst koji svi mogu citirati, ali niko ne mora slijediti.

Zašto je ovo uopšte bitno

Ovakvi dokumenti nisu tu da odmah promijene ponašanje velikih sila. Oni služe da postave normu: da se kaže šta se smatra „odgovornim“, a šta rizičnim ili neprihvatljivim. Male i srednje države su to prepoznale i potpisale, nadajući se da će pravila ograničiti saveznike isto koliko i potencijalne protivnike.

Problem nastaje kada najveći igrači procijene da im i simbolična ograničenja više štete nego što koriste. Tada norma ostaje bez centra gravitacije. Umjesto kočnice, postaje moralna fusnota.

Šta se previđa u javnoj priči

Deklaracija se fokusira na vojnu upotrebu AI-ja, ali ne i na kompanije koje razvijaju modele, prodaju ih ili ih prilagođavaju državama. To je ključna rupa. Ako se razvoj odvija bez jasnih obaveza, a „odgovornost“ počinje tek u uniformi, lanac odluka je već prekinut.

Tu je i pitanje povjerenja. Već danas potrošački AI sistemi imaju problem sa pouzdanošću, halucinacijama i prevelikom samouvjerenošću u pogrešnim odgovorima. U vojnom kontekstu, takva samouvjerenost softvera postaje politički problem: ko snosi odgovornost kada sistem zvuči sigurno, a odluka vodi u eskalaciju?

Šira slika

Ovaj pokušaj dogovora podsjeća na rane faze kontrole nuklearnog naoružanja: puno retorike, malo verifikacije i stalni strah da će neko drugi igrati bez pravila. Razlika je u brzini. AI se razvija daleko brže, a granica između civilne i vojne upotrebe je znatno mutnija.

Dok kompanije objavljuju sopstvene „sigurnosne principe“ i istovremeno jure ka snažnijim modelima, države su ostavljene da biraju između sporog dogovora i brze trke. U takvom okruženju, neobavezujući sporazumi lako postaju etiketa dobrih namjera, a ne stvarna zaštita.

Na kraju, pitanje nije da li su pravila loša, već da li pravila bez najmoćnijih učesnika zaista mogu usporiti nešto što svi žele da ubrzaju.