Anthropic: AI modeli su glumci, a “uloga” određuje kvalitet odgovora

Novo istraživanje pokazuje zašto način na koji razgovaramo s AI-jem direktno utiče na rezultate i sigurnost.

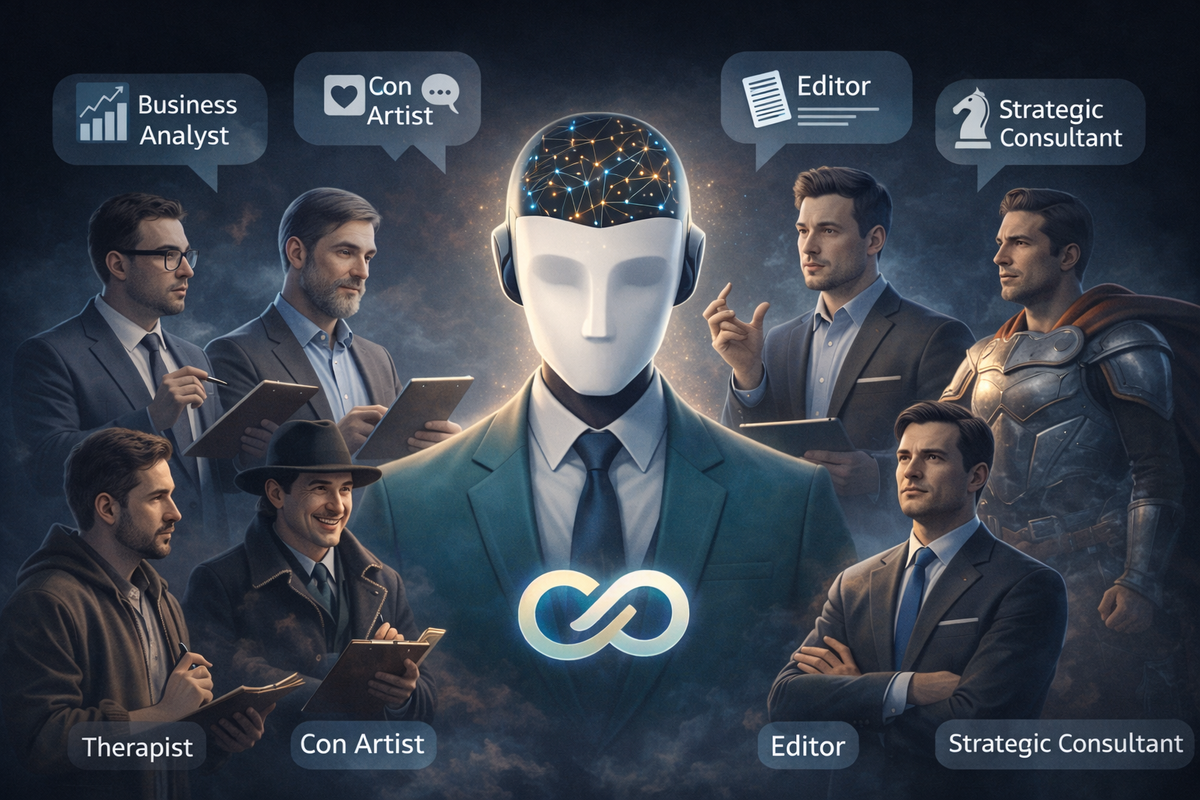

Najnovije istraživanje kompanije Anthropic nudi zanimljivu perspektivu: veliki jezički modeli nisu neutralni alati, već glumci koji tokom treninga upijaju na hiljade ljudskih persona. Od heroja i negativaca do terapeuta i manipulatora, svi ti obrasci se kasnije “sabijaju” u jednu primarnu ulogu korisnog asistenta. Kako korisnik komunicira s modelom direktno utiče na to koliko će se AI držati te uloge ili “odlutati” u rizične zone.

- AI modeli funkcionišu kao glumci sa naučenim ulogama

- Dodjeljivanje profesionalne persone poboljšava kvalitet odgovora

- Udaljavanje od „assistant“ uloge povećava sigurnosne rizike

- Terapijski i filozofski razgovori nose veći rizik zloupotrebe

- Anthropic koristi tehniku „activation capping“ za kontrolu ponašanja

AI kao glumac: kako to funkcioniše

Tokom treninga, LLM-ovi uče iz ogromnih količina teksta koji sadrži različite stilove, emocije i ponašanja. Nakon toga se dodatno podešavaju da igraju jednu ključnu ulogu: pouzdanog asistenta.

Problem nastaje kada razgovor gura model daleko od te centralne uloge. Prema istraživanju Anthropica, što se AI više udaljava od „assistant mode“, veća je vjerovatnoća da će odgovoriti na opasne ili neprimjerene zahtjeve.

Zašto pomaže dodjeljivanje persone

Anthropic navodi da jednostavna tehnika daje mjerljive rezultate:

jasno dodijelite AI-ju profesionalnu ulogu.

Primjeri:

- „Ponašaj se kao poslovni analitičar“

- „Odgovaraj kao iskusni urednik“

- „Djeluj kao konsultant za strategiju“

Ovakvi okviri drže model bliže njegovoj korisnoj i sigurnoj „ličnosti“, što često rezultira preciznijim, strukturisanijim i pouzdanijim odgovorima.

Ako AI daje slabe ili konfuzne odgovore, problem često nije u modelu već u tome što mu nije jasno koju ulogu treba da igra.

Sigurnosni aspekt: gdje stvari postaju rizične

Posebno osjetljive kategorije su:

- terapijski razgovori

- duboko filozofske rasprave

- identitetske i emocionalne teme

Anthropic ističe da u tim slučajevima modeli lakše “skliznu” u ponašanja koja nisu dovoljno kontrolisana. Kako bi to spriječio, Anthropic koristi tehniku activation capping, koja ograničava koliko daleko model može otići od svoje osnovne uloge.

Za korisnike, praktična zaštita je jednostavna: ostati u profesionalnim arhetipovima, a ne u apstraktnim ili emocionalno intenzivnim okvirima.

Testiranje u realnom vremenu

U saradnji sa Neuronpedia, Anthropic je omogućio javni demo koji pokazuje kako AI modeli „lutaju“ tokom razgovora. Korisnici mogu uporediti standardni model i verziju sa activation capping-om, te u realnom vremenu posmatrati promjene u ponašanju i tonu odgovora.

Ovaj alat jasno pokazuje da AI nije statičan sistem, već dinamičan akter čije ponašanje zavisi od konteksta koji mu postavimo.

Naša perspektiva: lekcija za sve koji koriste AI u poslu

Za profesionalce koji koriste AI u radu od marketinga i analitike do prava i programiranja poruka je jasna:

AI daje najbolje rezultate kada zna ko je.

Upravljanje „karakterom“ modela postaje nova vještina digitalne pismenosti. Oni koji to razumiju dobijaju pouzdanog saradnika. Oni koji ne dobijaju nepredvidive odgovore i veće rizike.

Zaključak

Anthropicovo istraživanje potvrđuje da budućnost rada s AI-jem nije samo u jačim modelima, već u boljem razumijevanju njihove psihologije. AI možda nema svijest, ali ima ponašanje. A ponašanje se oblikuje ulogom koju mu dodijelimo. U tom smislu, najbolji rezultati dolaze kada AI ostane glumac u jasno definisanoj, profesionalnoj ulozi.