Amazon Bedrock AgentCore: Da li AI agenti konačno postaju naučnici?

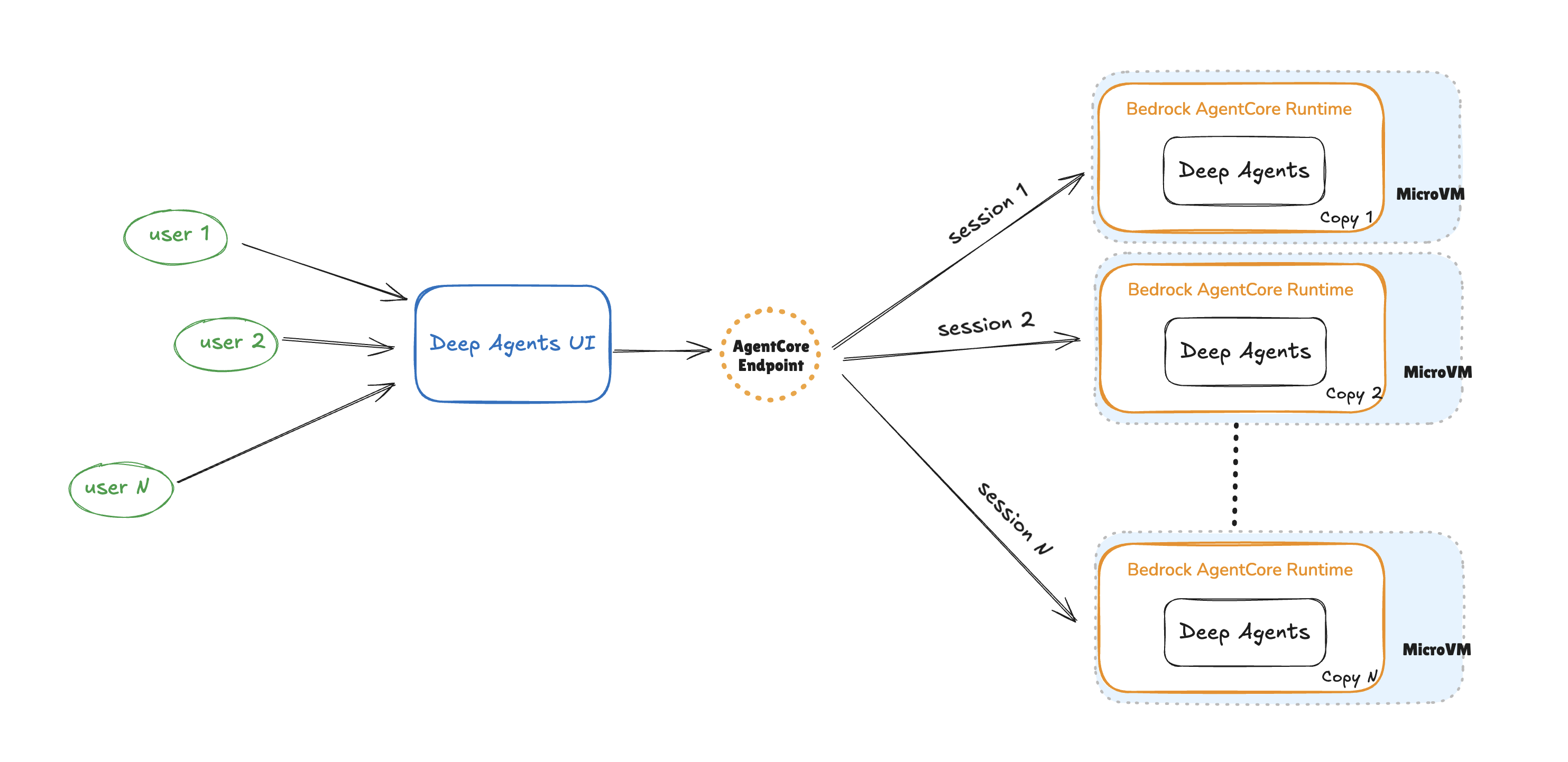

Šta kada bi vještačka inteligencija mogla preuzeti ulogu istraživača na najvišem naučnom nivou? Ne govorimo o digitalnom asistentu koji šalje mailove, već o entitetu koji smišlja hipoteze, dizajnira eksperimente i analizira haotične podatke brže od najboljih laboratorija svijeta. Amazon je najavio lansiranje Bedrock AgentCore, platforme koja razbija postojećepretpostavke o mogućnostima AI agenata baš u naučnim istraživanjima.

Kada kompanija veličine Amazona donese revoluciju u nauku, valja zastati. Ko su pobjednici, a ko potencijalni gubitnici ove trke?

- AgentCore dozvoljava naučnicima i istraživačima da pokreću AI agente koji automatski traže naučne članke, analiziraju eksperimentalne podatke i predlažu nove smjerove istraživanja.

- Više ne govorimo o običnim chatbotovima, već o takozvanim 'deep research agentima' vještačkoj inteligenciji sposobnoj da generiše i testira ideje nezamislivom brzinom.

- Po Amazonu, platforma je potpuno prilagodljiva i skalabilna, integrišući se s popularnim LLM-ovima kao što su Claude 3 i Anthropic, te omogućavajući rad s personalizovanim skupovima podataka korisnika.

'Kreirali smo AgentCore da naučnicima otvorimo potpuno novi način razmišljanja i istraživanja', ističu autori na zvaničnom AWS blogu.

Zamislite prostoriju prepunu genijalaca koji na desetine jezika istovremeno analiziraju milione eksperimenta to je vizija AgentCore-a. Ali, dok korporacije slave, kritičari ulažu glas: Ko kontroliše ideje? Šta kada vještačka inteligencija napravi otkriće koje čovjek ne može objasniti niti provjeriti? I najvažnije: kakvu cijenu ćemo platiti kad sigurnosne barijere popuste pred inovacijom? Ovo nisu samo tehnička pitanja. Već danas, čitava naučna zajednica mora odlučiti hoće li prihvatiti novo doba istraživanja, ili će pokušati održati postojeća pravila igre?