Neka ChatGPT piše prompt umjesto vas.

Novi pristup skida „magiju“ sa promptova: zadatak se definiše programatski, a model sam optimizuje upute na osnovu eval podataka.

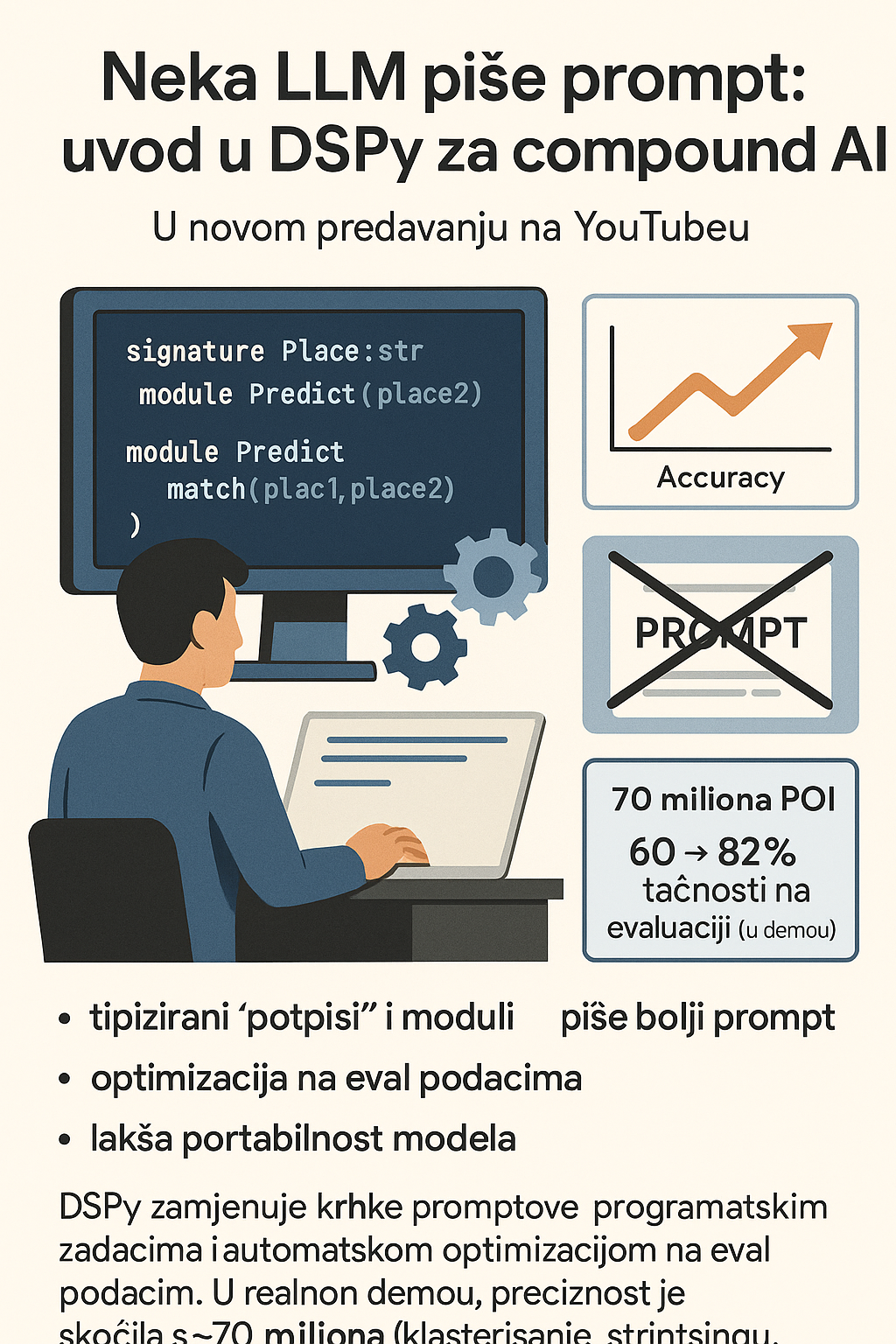

U predavanju “Let the LLM Write the Prompts”, Drew Brunig objašnjava zašto su ručno pisani promptovi krhki, netransparentni i teško prenosivi između modela i kako DSPy to rješava: umjesto zidova teksta, definišete tipizirane potpise (inputs/outputs) i module (strategije), a zatim automatski optimizujete upute na svom eval skupu. Rezultat su mjerljivi dobici, čistiji kod i lakša portabilnost.

Problem s promptovima: krhkost i „catch-all“ logika

Promptovi su „dar i prokletstvo“: brzi za početak i samodokumentuju se, ali u praksi postaju krhki, zavise od modela i pretvaraju se u improvizovani skup hot-fixova. „Zvuči poznato? ‘Ne briši ovu liniju’ u kodu to je prompting ekvivalent“, kaže Brunig. U velikim kodnim bazama prompt je često nečitljiv blok teksta bez jasnih komponenti (zadatak, primjeri, alati, formatiranje).

DSPy: potpis + modul umjesto zidova teksta

DSPy razdvaja šta od kako:

- Signature (“potpis”) opisuje ulaze/izlaze i tipove — npr.

Place(name, address)→match: bool,confidence: {low, medium, high}. - Module bira strategiju (npr.

Predict,ChainOfThought,ReAct, većinsko glasanje).

Ista logika se može prepakovati za drugi model promjenom jedne linije, bez ručnog prepisivanja dugih sistemskih promptova ili JSON parsiranja.

„Pišemo zadatke, ne promptove. Kada se pojavi bolja strategija sjutra, samo zamijenite modul“, poručuje Brunig.

Optimizacija na evaluaciji: model piše bolji prompt

Umjesto ručnog „tweakovanja“, DSPy generiše i testira više kandidata za prompt (npr. preko optimizatora poput MiPRo/MiRO), spaja najbolje dijelove i vraća optimizovanu verziju verzionisanu kao JSON. U demou, preciznost na označenom eval skupu skočila je s ~60% na ~82% bez ručnog pisanja prompta, a zatim dodatno rasla pri prebacivanju na druge modele, uz istu task-definiciju.

„Eval podaci su zlato; promptovi su potrošna roba“, naglašava Brunig.

Primjer iz prakse: Overture Maps i spajanje 70M POI

Za Overture Maps Foundation, gdje više timova održava matcher preko cloudova i modela, DSPy je iskorišten za spajanje podataka o ~70 miliona mjesta (POI) iz više izvora. Većina parova rješava se klasičnim metodama (klasterisanje, string sličnosti, embedding distance), a LLM ulijeće selektivno za teške slučajeve uz jasne potpise, mjerljivu metriku i prenosive module.

Zašto je važno: portabilnost, governance i brzina

- Model-agnostičnost: promijenite model, ponovo pokrenite optimizator, zadržite isti „potpis“.

- Mjerljivost: svaka izmjena prolazi kroz eval metriku/„reward“ funkciju.

- Čitljivost i verzionisanje: promptovi kao artefakti (JSON), a ne „magija“ u f-stringu.

- Skaliranje tima: manje tribalnog znanja, više reproducibilnosti.

„Sutra će stići nova strategija i jeftiniji model. Ne vežite se za prompt vežite se za zadatak i evaluaciju“, rekao je Drew Brunig, predavač.

Fact-box

- 70+ miliona POI u pipelineu Overture Maps.

- Demo: ~60% → ~82% tačnosti nakon automatske optimizacije prompta.

- Prompt/strategija se verzioniše i prenosi između modela uz minimalne izmjene.

Šta slijedi

DSPy dobija nove optimizatore (npr. „Simba“ u najavljenom 3.0), lakšu finu doradu i slaganje više modula u jedinstven tok. Za timove koji grade compound AI pipelinee, ovo znači manje ručnih „zakrpa“, a više kontrolisanog učenja nad vlastitim podacima.