MIT je riješio problem memorije u AI modelima.

Istraživači sa MIT-a predlažu novi pristup memoriji vještačke inteligencije koji se ne oslanja na ogromne kontekstne prozore.

Godinama se smatralo da je rješenje za „zaboravljanje“ kod vještačke inteligencije jednostavno: povećati kontekstni prozor i ubaciti više teksta. Međutim, novi rad istraživača sa MIT CSAIL pokazuje da problem nije u količini podataka, već u načinu na koji se oni koriste. U radu se predstavljaju Rekurzivni jezički modeli (Recursive Language Models – RLM), koji omogućavaju modelima da „navigiraju“ kroz velike dokumente umjesto da pokušavaju sve da zapamte odjednom.

- MIT predstavlja Rekurzivne jezičke modele kao alternativu velikim kontekstnim prozorima.

- Modeli koriste rekurzivne pozive da bi obrađivali i do 100 puta veće ulaze.

- RLM sistemi održavaju stabilnu tačnost i do milion tokena.

- Računski troškovi su znatno manji u poređenju sa klasičnim dugim kontekstom.

- Kod je objavljen kao open-source projekat.

Analiza: kako funkcionišu rekurzivni modeli

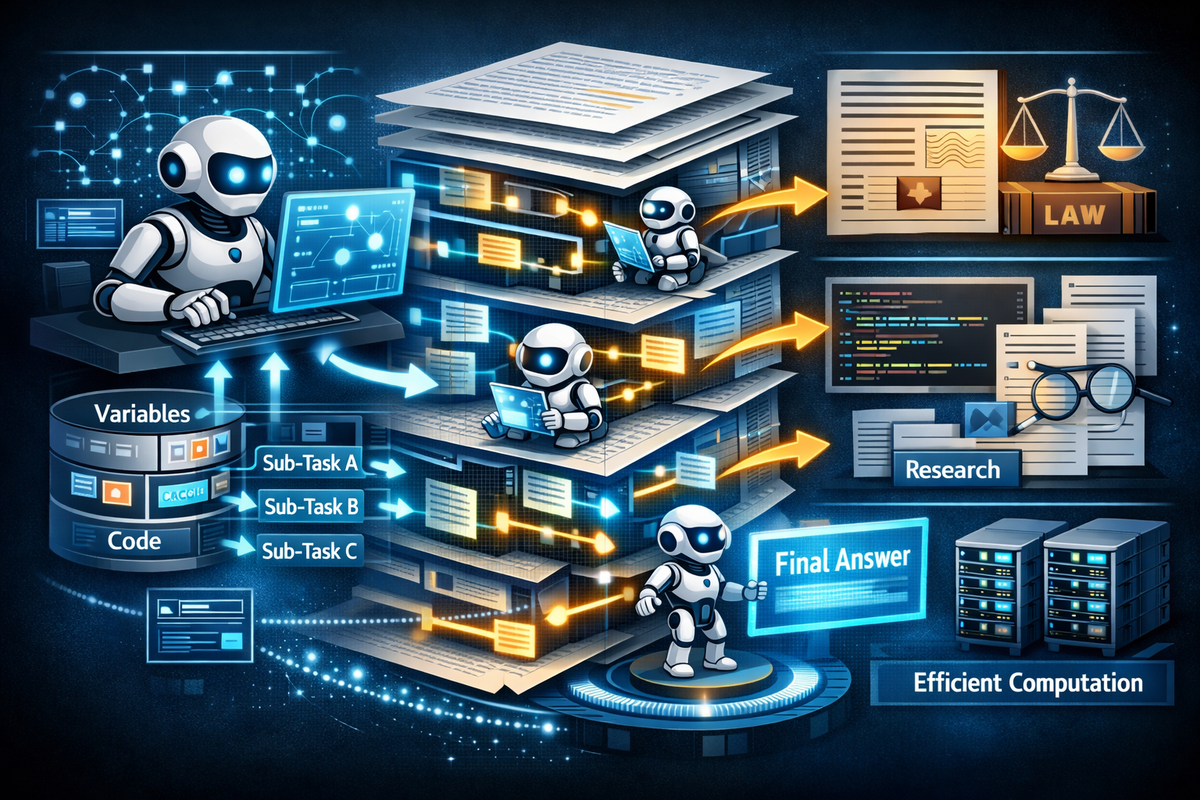

Rekurzivni jezički modeli tretiraju velike dokumente kao okruženje koje se može istraživati po potrebi. Umjesto da cijeli tekst bude u memoriji u jednom trenutku, model koristi Python-bazirani sistem varijabli i programatski generisane pod pozive. Na taj način aktivira samo one dijelove teksta koji su relevantni za trenutni korak rezonovanja.

Prema radu, RLM-om prošireni modeli održavaju stabilnu tačnost čak i pri radu sa dokumentima veličine do milion tokena, što je daleko iznad standardnih limita. Ovo direktno rješava problem tzv. „context rot“ efekta, gdje modeli gube koherentnost kako se kontekst širi.

Tržište i konkurencija: RLM naspram RAG pristupa

Do sada je najčešće rješenje za rad sa velikim količinama podataka bio Retrieval-Augmented Generation (RAG). Iako efikasan u jednostavnijim scenarijima, RAG često posustaje kod kompleksnih zadataka koji zahtijevaju višestruke unakrsne reference.

U poređenju s tim, RLM sistemi selektivno „ulaze“ u dokument više puta, zadržavajući logiku rezonovanja. Testovi iz rada pokazuju da RLM nadmašuje RAG u složenim zadacima analize pravnih dokumenata, velikih kodnih baza i istraživačkih arhiva.

Važno je i to što se izbjegavaju kvadratni troškovi računanja karakteristični za transformere sa dugim kontekstom, jer se obrađuju samo mali, relevantni dijelovi podataka.

Naša perspektiva: šta ovo znači za region i poslovne korisnike

Za firme u regionu koje koriste AI u poslovanju od pravnih kancelarija do IT kompanija i istraživačkih timova ovo može biti prelomna tačka. Umjesto skupih sistema koji zahtijevaju ogromne resurse, RLM pristup omogućava efikasniju analizu velikih internih baza znanja.

Posebno je značajno što je implementacija objavljena kao open-source projekat u saradnji sa Prime Intellect, što otvara prostor za prilagođavanje i eksperimentisanje čak i manjim timovima.

Zaključak

Rad koji vodi Alex Zhang pokazuje da budućnost AI memorije ne leži u pukom povećavanju kapaciteta, već u inteligentnoj navigaciji kroz podatke. Rekurzivni modeli ukazuju na smjer u kojem će AI sistemi bolje „znati gdje da traže“, umjesto da pokušavaju sve da zapamte. To bi moglo produžiti vijek upotrebljivosti AI rješenja u kompleksnim poslovnim i istraživačkim okruženjima.